去年寒假接到了一个遥感图像语义分割的任务,存在着严重的类别不平衡问题。当时想着使用经典的类别不平衡损失 focal loss 和 dice loss 解决一下,但是效果不升反降,甚至不如传统的交叉熵损失函数。

而且我在 github 上搜类似的项目,也都不推荐使用这些 loss。但是在 mmseg 的文档中,我们又发现 dice loss 有明显的提升,来冷静分析一下这是为什么。本文默认读者了解 focal loss 和 dice loss,因此不会对损失函数进行讲解。

去年寒假接到了一个遥感图像语义分割的任务,存在着严重的类别不平衡问题。当时想着使用经典的类别不平衡损失 focal loss 和 dice loss 解决一下,但是效果不升反降,甚至不如传统的交叉熵损失函数。

而且我在 github 上搜类似的项目,也都不推荐使用这些 loss。但是在 mmseg 的文档中,我们又发现 dice loss 有明显的提升,来冷静分析一下这是为什么。本文默认读者了解 focal loss 和 dice loss,因此不会对损失函数进行讲解。

之后的日子,大概会放缓刷题的脚步进行简单的整理,因为有些题目是有规律的,需要做号总结和整理,不能刷一个忘一个。今日总结:题目要求返回所有结果,且能找到分界点分解为子问题的,都可以套用分治枚举算法。

书接上文,因为参加 NLP 的比赛不知道什么是 bert 实在有点说不过去,于是花了三天时间看了下 bert 的基本概念和代码。不得不说,网上阳间的 bert 预训练代码太少了,大多是转载,mark 甚至文不对题之类没啥用的东西,但占据了搜索引擎的首页的热度,像无耻的营销号一样。

阿里灵杰问天引擎电商搜索算法赛,来详细的记录一下参加这个天池比赛的流程以及我眼中的检索。因为之前从未涉足 NLP 领域,对 NLP 的了解也仅限于大二的时候看完《数学之美》手写过 TF-IDF 算法,我甚至不知道什么是 bert。

为了防止更多的人踩坑,能愉快的参与进来,于是决定把我的做法和程序分享出来,供参赛选手参考。之前在交流群里大概说了我的做法,私聊我的人我也都告诉了他们大概怎么去做,在那几天看到好多人在排名突飞猛进保送到了 0.2 分左右,甚至超过了我,还是比较开心的。这次做一个系统的分享,我甚至会告诉你怎么做是不对的,也希望你能有更创新的想法。走过路过给我的 github 点个 star 就行了,孩子要秋招了,这对我比较重要。(2022年3月20日,0.22的得分排名 21,3月24日,这个得分只能90名,大家太卷了)。

最近用 yolox 的发现了一个很神奇的现象,简而言之 yolox-tiny 在单目标检测的效果比 yolox-small 好上很多(3.2mAP%),且 yolox-small 能大幅提升检测精度的方法到了 yolox-tiny 也不起作用了。网上很多 yolox 的解读基本都是翻译论文,没啥价值,还是决定仔细读一下代码,这大概也是全网第一份从源代码的角度解析 yolox 的文章。

阅读源码后发现 yolox 的 SimOTA 机制存在一些漏洞,并使用对应的方法调优。调优过程明确不采用的方案:增大模型规模、模型融合和其他消耗算力的方法,专注算法本身。

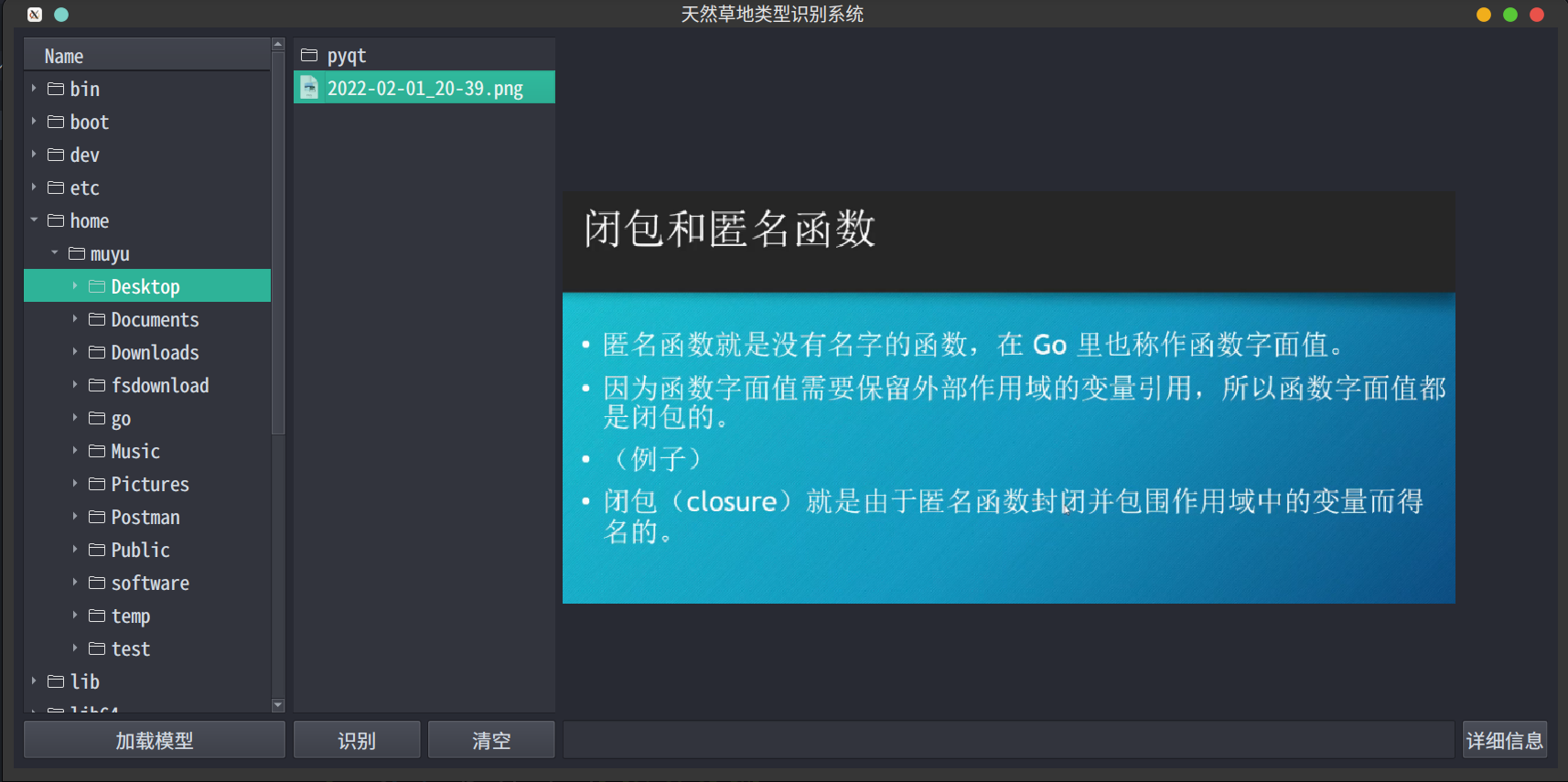

寒假某天下午的突发奇想,想实现一款图像预览软件。大概思路是:在软件的左侧点击图片,软件的右侧就能实时预览图片,因为感觉这个功能有一定的应用场景,所以实现了一下。

时间有些晚了,选一个词来描述今年的话,现实魔幻主义,孤魂野鬼又一年。现实比魔幻还要魔幻,魔幻比现实还要现实。